Mehr als 200 Jahre solide Klimaforschung – wie viel braucht es noch?

Worauf basieren antidemokratische rechte Parteien wie die AfD ihre Behauptung es gäbe keinen anthropogenen globalen Klimawandel, obwohl dessen Existenz auf 200 Jahren solider Wissenschaft basiert?„.

Ein Antworter auf Quora empörte sich über meine anmaßende Annahme die AfD sei undemokratisch (dazu empfehle ich DIESEN ARTIKEL), während ein weiterer Autor mir schrieb: „Es gibt keine 200 Jahre solide Wissenschaft. Überprüfen Sie dazu einfach das wissenschaftliche Weltbild um 1820, … Sie werden mit der Stirn runzeln, wenn nicht gar lachen.“

Nun. DAS konnte ich so nicht stehen lassen…

Sicher hat der gute Mensch recht, wenn er auf das in der Allgemeinheit damals vorherrschende „wissenschaftliche Weltbild“ abzielt, das auch in unserer Zeit ausgesprochen verzerrt ist. Wissenschaftshistorisch dagegen sieht die Sachlage vollkommen anders aus. Offensichtlich gab es vor 200 Jahren hochauflösende LIDAR Spektroskopie der Atmosphäre ebenso wenig wie kontinuierliche globale satellitenbasierte Messdatenerfassung oder die Modellierung globaler Zirkulationsmodelle auf Supercomputern oder verteilten Rechnern. Wissenschaft ist aber ein laufendes Projekt, und viele der Grundlagen dessen, was aktuelle Spitzenforschung ausmacht, wurden vor rund 200 Jahren – und z.T. noch weit länger zurück – gelegt. Ich nenne nur einige Beispiele, die mir adhoc einfallen:

Die empirische Seite:

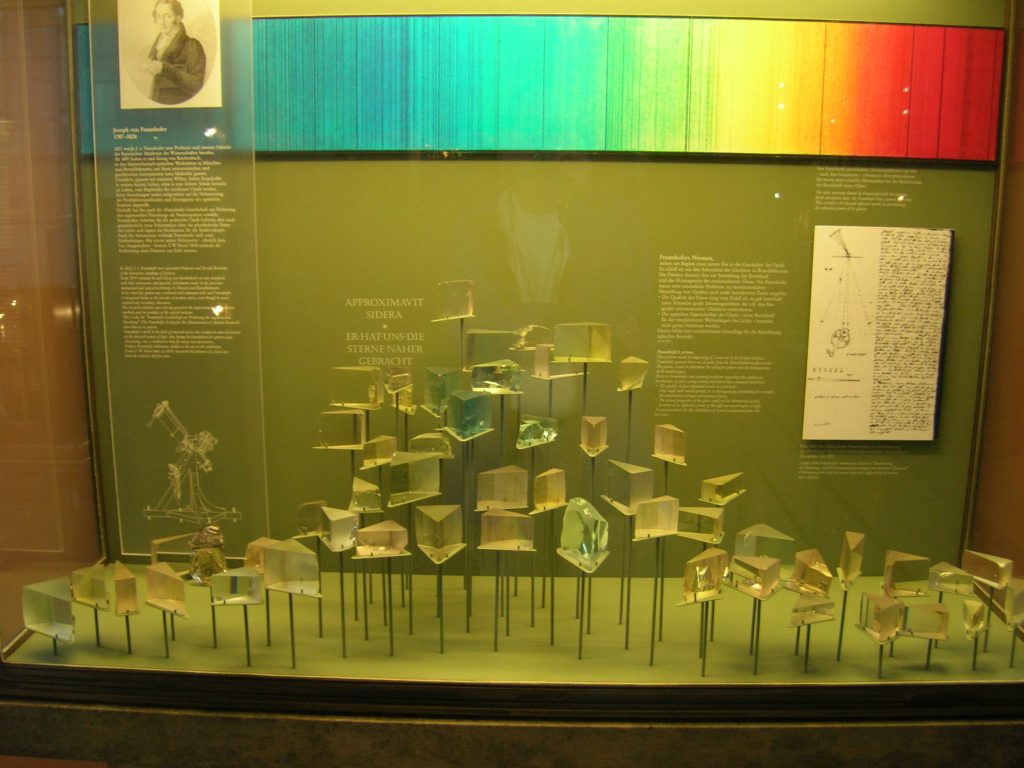

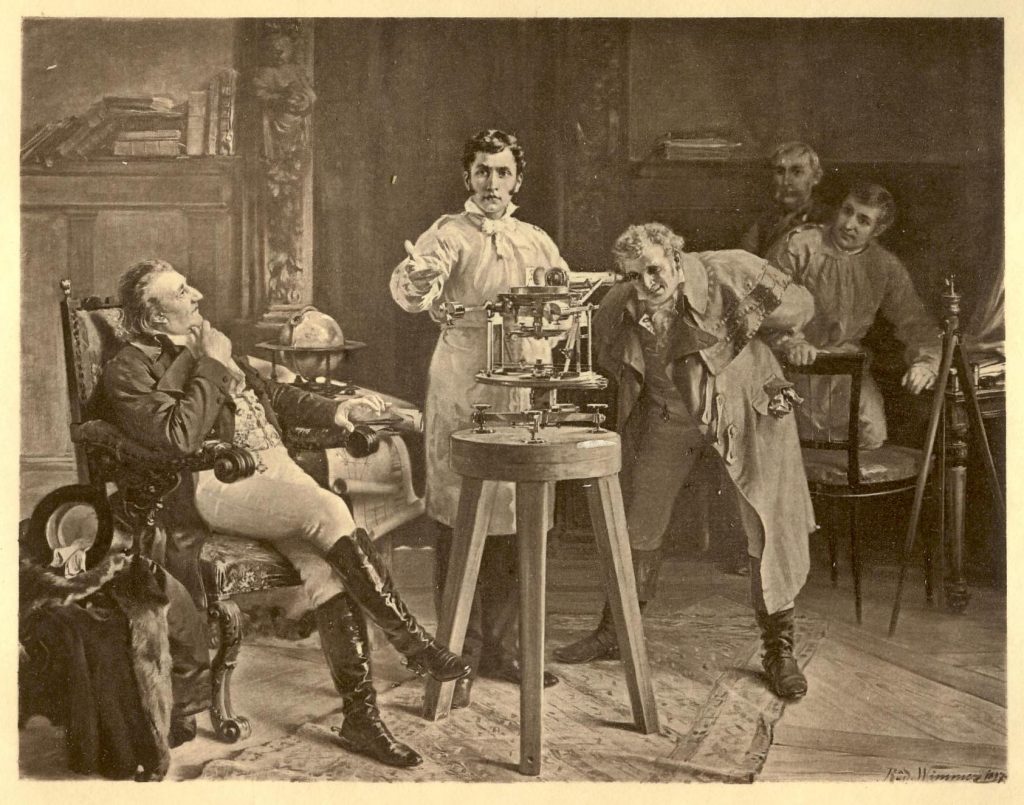

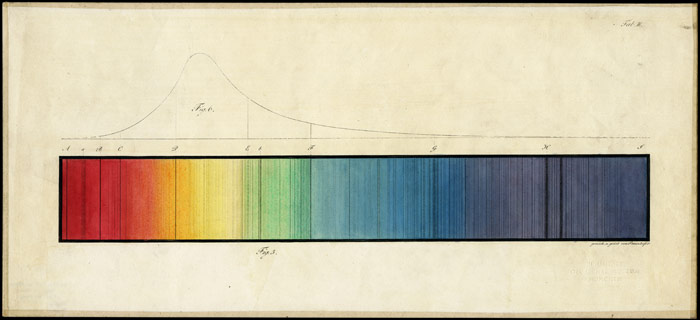

1814 entdeckte Joseph von Fraunhofer mit Hilfe des ebenfalls in diesem Jahr von ihm erfundenen Spektroskopen die nach ihm benannten Spektrallinien im Sonnenspektrum, die durch atomare Resonanzabsorption in den vom Licht durchlaufenen Gasen der Sonnenatmosphäre entstehen. Das Verständnis dieser Absorptionsvorgänge, die wellenlängenabhängig in bestimmten Gasen auftreten, ist eine der Grundlagen für das Verständnis des Effektes der Strahlungsverstärkung (radiative forcing) durch bestimmte Gase (irreführend als „Treibhausgase“ bezeichnet) wie CO2, Methan etc. Spektroskopie ist eine empirische Schlüsselmethode für die Atmosphärenforschung. Heute stehen wir kurz vor der Möglichkeit mit letztlich auf Fraunhofer zurückgehenden Methoden selbst die Zusammensetzung von Atmosphären extrasolarer Planeten in Entfernungen von dutzenden von Lichtjahren zu untersuchen.

Museums Exponat mit Fraunhofer Prismen, illustration der Spektrallinien und Original Manuskript

Joseph Fraunhofer präsentiert sein Spektroskop

Photo der ersten Originalzeichnung Fraunhofers des solaren Absoprtionsspektrums, Original im Deutschen Museum München

1824 veröffentlichte Jean-Baptiste Joseph Fourier, ebenfalls ein Pionier der Spektroskopie aber auch der Thermodynamik (siehe Fouriersches Gesetz zur Wärmeausbreitung), eine umfassende Arbeit zur Thermodynamik der Atmosphäre, in der bereits die wesentlichen Elemente des sogenannten Treibhauseffektes enthalten sind („Mémoire sur les Température du Globe Terrestre et des Espaces Planétaires“). Hierin bezog er sich auf frühere experimentelle Arbeiten des Genfer Naturwissenschaftlers Horace Bénédict de Saussure (17 February 1740 – 22 January 1799). Letzterer erfand oder verbesserte zudem eine ganze Reihe von Messgeräten der Atmosphärenforschung, darunter das erste elektrische Anemometer sowie Evaporimeter, Eudiometer, Magnetometer, Diphanometer und Cyanometer. Moderne Varianten all dieser Instrumente sind heute über das ganze Sonnensystem verteilt.

Fourier war zusätzlich auch der erste, der die Bedeutung der Konvektion für die Dynamik und Thermodynamik der Atmosphäre erkannte.

1656 leitete Robert Boyle mit Experimenten die auf den vorangegangenen Versuchen Otto von Guerickes aufbauten die erste Formulierung der idealen Gasgleichung experimentell her. Daraus gingen in der Folge die bekannten Gesetze von Boyle-Mariotte (1662) , Gay-Lussac bzw. Charles (1787 / 1802) und Amonton (der 1705 starb und u.a. als erster den absoluten Nullpunkt postulierte). Ohne diese Erkenntnisse wäre Atmosphärenforschung nicht möglich.

Im weiteren Verlauf des 19. Jh entwickelte sich die Thermodynamik und Gastheorie rasant weiter. Ich lasse einfach einige Namen fallen, sonst müßte ich ein dickes Buch schreiben: Carnot, Thomson, Clausius, Maxwell, Boltzmann, Gibbs, Zeuner, de Waals u.v.m. – der physikalische Systembegriff wurde entwickelt, statistische Thermodynamik hielt Einzug, mathematische Modellierung komplexer Systeme – das 19. Jahrhundert war eine wissenschaftlich extrem produktive Zeit!

Ein weiterer wissenschaftlicher Vordenker der modernen Geo-Systemforschung (was der korrektere Begriff für das ist, was medial als „Klimaforschung“ durch das Dorf getrieben wird) ist natürlich Alexander von Humboldt, gewissermaßen der Vater des vernetzten interdisziplinären wissenschaftlichen Denkens. Er sprach bereits 1800 vom Klimawandel. Siehe z.B.: Alexander von Humboldt: 200 Jahre Klimawandel – WELT

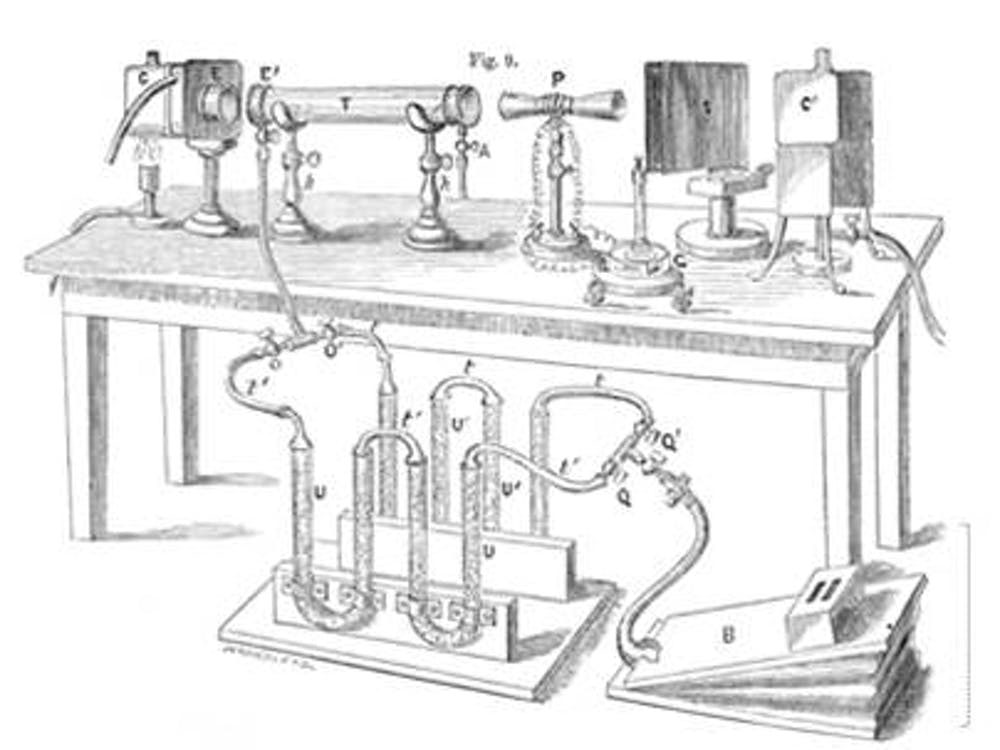

Ebenfalls bahnbrechend (1861): John Tyndals experimentell basierte Schlüsselarbeit, „On the Absorption and Radiation of Heat by Gases and Vapours, and on the Physical Connexion of Radiation, Absorption and Conduction“

Tyndalls experimentaler Aufbau zur Untersuchung der spektralen Eigenschaften atmosphärischer Gase (c) Ed Hawkins, University of Reading

Und nicht zu vergessen DAS Geburtspapier der modernen Erforschung der CO2 Strahlungsverstärkung in der Erdatmosphäre (1896): Svanthe Arrhenius, „On the Influence of carbonic acid in the air upon the temperature on the ground.“ Und das war nur einer seiner vielen Beiträge zum Thema – man denke an das „Arrhenius Gesetz“, das hoffentlich die meisten aus der Schule kennen. Aber wer weiß…

Theorie:

1686 präsentierte der Britische Physiker George Hadley seine Theorie zur Entstehung der Passatwinde und der globalen atmosphärischen Zirkulation. Er berücksichtigte dabei als erster systematisch, daß die Erde ein rotierendes Bezugssystem ist. Die exakte Ableitung der später so genannten Corioliskraft gelang allerdings erst 1749 durch Euler, und Laplace integrierte Eulers Ableitung kurz darauf in seine Gezeitengleichungen, in denen unter anderem Frequenz und Amplituden systemischer Schwingungen, Windstau, Einflüsse von Mond und Sonne berücksichtigt werden. All das sind Grundlagen moderner Geo-Systemanalyse und Modellierung. Eine Verfeinerung und Präzisierung des Konzeptes erfolgt 1835 durch Gustave de Coriolis. Die Corioliskraft ist einer der wichtigsten Faktoren bei der Entstehung von (Wirbel–) Stürmen sowie für das Verständnis der atmosphärischen Zirkulation und der Meeresströmungen.

Was gerne übersehen wird ist, daß moderne Wissenschaft auf methodischen Fundamenten ruht, die letztlich über Jahrtausende herausgearbeitet werden. Moderne Forschung bedient sich hoch entwickelter Mathematik, und die Grundlagen der modernen Infinitesimalrechnung, Linearen Algebra und numerischen Mathematik wurden vor allem von Leuten wie Newton, Leibniz, Taylor und Lagrange zwischen ca. 1670 und 1815 entwickelt. Diese Mathematik ist im Wesentlichen dieselbe Mathematik, auf der heutige Methoden zur Datenanalyse und moderne Modellrechnungen aufbauen.

Fazit:

Es gäbe noch endlos weitere Beispiele aus den Bereichen theoretische und synoptische Meteorologie, Ozeanographie, Geographie, Hydrodynamik, Astronomie und anderen Gebieten, in denen vom 17. bis zum Ende des 19. Jh empirische Erkenntnisse gewonnen und solide Theorien und Methoden entwickelt wurden, und ich habe sicher eine Reihe Leute mit wesentlichen Beiträgen hier vergessen. Wenn überhaupt, dann könnte man mir vorwerfen, die „200 Jahre solide Wissenschaft“ seien viel zu kurz gegriffen. Mir ging es nur darum klar zu machen, daß meine Aussage ztu 200 Jahren solider Wissenschaft nicht leichtfertig aus der Luft gegriffen war. Im 20sten Jh hat sich natürlich das Erkenntniswachstum im Bereich der Geo-Systemforschung exponentiell weiterentwickelt.

See also: A Brief History of Climate Change by Ed Hawkins, University of Reading